Article – 3 avantages liés à l’utilisation de containers à l’Edge

Des véhicules connectés aux bennes intelligentes, le monde physique se barde de capteurs. Grâce à l’Edge Computing, ces données pourront être traitées localement, avec à la clé, un temps de latence réduit pour une meilleure expérience utilisateur. Comment y parvenir avec la technologie des containers ? Explications avec Antonin Anchisi, Product Owner DevOps, et Pierre Melnotte, Cloud Solution Architect chez Orange Business.

D’ici 2025, les objets connectés généreront 73,1 zettaoctets de données selon IDC. Une quantité importante qui touche tous les secteurs d’activité. Face à cette croissance, les entreprises doivent prendre en compte les problèmes de latence et de bande passante qui pourraient survenir et impacter de manière négative l’expérience utilisateur.

Surtout lorsque la source de création de données est éloignée du centre de données primaire. En effet « lorsque l’on utilise un cloud public, il faut s’appuyer sur les datacenters mis à disposition par le fournisseur et ces derniers ne sont pas toujours au plus près des sources de données, affirme Antonin Anchisi. Or pour certains besoins, il est nécessaire de pouvoir traiter les données au plus près de là où elles sont générées ». C’est particulièrement le cas des organisations contraintes par des normes de sécurité et de confidentialité tels que les soins de santé, et qui doivent traiter tout ou une partie de leurs données en local. D’où l’intérêt de s’appuyer sur des solutions de type Edge pour « continuer à piloter l’ensemble des infrastructures IT et objets connectés depuis un point central » complète Pierre Melnotte.

Une infrastructure IT solide, sécurisée et intelligente est donc indispensable pour intégrer tout ce nouveau flux de données issu de l’Internet des Objets (IoT) et désengorger le trafic en direction du cloud. Mais qu’en est-il des containers ? Voici les 3 grands avantages qu’apportent les containers pour accélérer vos projets d’Edge Computing.

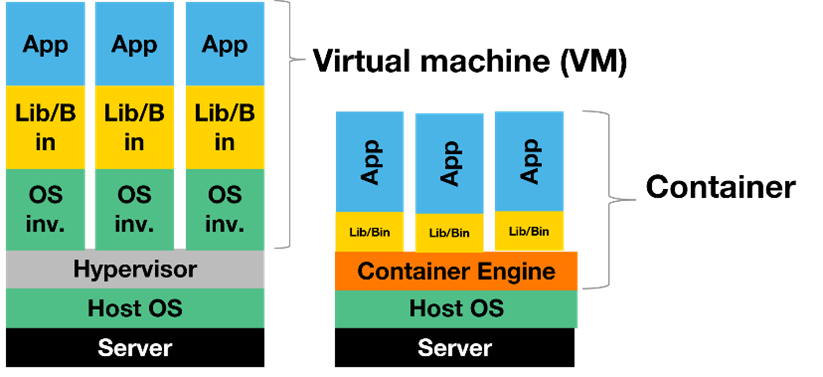

Avantage #1 : une structure légère qui facilite le déploiement d’applications

Contrairement aux machines virtuelles (VM) qui peuvent occuper des gigaoctets (Go) d’espace, les containers offrent une solution plus légère avec une empreinte qui s’exprime en mégaoctets (Mo). Cette légèreté s’explique par la structure simplifiée du container, qui permet à la fois :

- Une migration rapide d’applications entre différents environnements.

- Une plus grande densité d’applications sur un même serveur.

Cette structure légère apporte dans un premier temps, plus de portabilité et de flexibilité aux projets Edge. « Une entreprise peut par exemple déployer rapidement une même application sur l’ensemble de ses sites et ce, quel que soit le matériel utilisé : serveur physique, machine virtuelle, nano ordinateur… » affirme Antonin Anchisi. En d’autres termes, les containers permettent aux entreprises de gagner en indépendance vis-à-vis de leurs matériels et d’assurer une gestion unifiée de leur parc applicatif.

Deuxièmement, cette structure légère accélère le développement d’applications puisqu’elle est adaptée aux besoins métiers des équipes IT : Les développeurs peuvent se concentrer sur la logique et les dépendances des applications (librairies…). Les spécialistes d’exploitation, quant à eux, peuvent gérer les problèmes de déploiement et de gestion des logiciels, sans se soucier des versions et des configurations des applications.

En somme, les containers permettent de déployer et mettre à jour plus rapidement les applications et les objets connectés situés en périphérie du réseau cloud.

Avantage #2 : la résilience en ligne de mire

Les containers sont particulièrement adaptés à l’architecture logicielle de type microservices, dans laquelle les composantes clés d’une application sont isolées des unes des autres. Le système est alors « découplé » et « asynchrone », contrairement à une architecture dite « monolithique ». Cela signifie qu’en cas d’incident, si un des services de l’application s’arrête, le système est à même de le détecter, et de le relancer ou de fonctionner en mode dégradé. Associés à l’Edge Computing, les containers utilisés dans le cas d’une structure en microservices, rajoutent ainsi une couche de résilience aux applications déployées en périphérie.

Au-delà de cette résilience intra-applicative, il est également possible de l’être au niveau de la stratégie réseau. Prenons l’exemple d’une caméra intelligente, utilisée dans l’industrie pour détecter des pièces défectueuses. « Les algorithmes utilisés pour construire le modèle d’intelligence artificielle (IA) sont entrainés dans le cloud pour bénéficier de toute la puissance de calcul de celui-ci. Une fois terminé, le modèle IA est déployé grâce aux containers vers l’Edge, précise Antonin Anchisi. Imaginons qu’il y ait une défaillance affectant le lien réseau entre le cloud et l’usine dans laquelle se trouve la caméra intelligente. Puisque le modèle a été déployé localement grâce aux containers, il serait alors possible d’assurer la continuité du service de la détection des pièces sans interruption, et ce malgré l’incident affectant le réseau ».

Avantage #3 : une compatibilité cross-services

De par leur structure plus légère et simplifiée, les containers offrent une plus grande compatibilité avec les objets connectés et environnements virtuels. Et pour Pierre Melnotte, cette tendance est là pour durer. Selon lui, de plus en plus de services disponibles sur les clouds publics seront compatibles avec un déploiement en Edge.

Article – NIS2, à quels types d’exigences votre organisation devra répondre et comment s’y préparer

Voir le contenu

Article – Entrée en vigueur de NIS 2 : Qui sera concerné ?

Voir le contenu

Brochure – Quels leviers de réduction d’impact environnemental à activer avec Cloud Avenue ?

Voir le contenu

Brochure – Améliorer l’empreinte carbone de votre SI ?

Voir le contenu

Brochure – Consommation énergétique et empreinte carbone dans l’IT ?

Voir le contenu

Brochure – comment orange business écoconçoit ses solutions et aide ses clients à écoconcevoir leurs applicatifs ?

Voir le contenu

Infographie – Indicateurs environnementaux des datacenters

Voir le contenu

Livre blanc – Comment réduire la consommation énergétique et l’impact environnemental des datacenters

Voir le contenu

Le PCR « datacenter et services cloud » de l’ADEME : collaboration et engagement d’Orange Business

L’Agence De l’Environnement et de la Maîtrise de l’Energie (ADEME) joue un rôle essentiel dans la promotion de pratiques durables et respectueuses de l’environnement. Dans…

Voir le contenu