Cloud Public Openstack – Flexible Engine

Distributed Cache Service (DCS)

Description

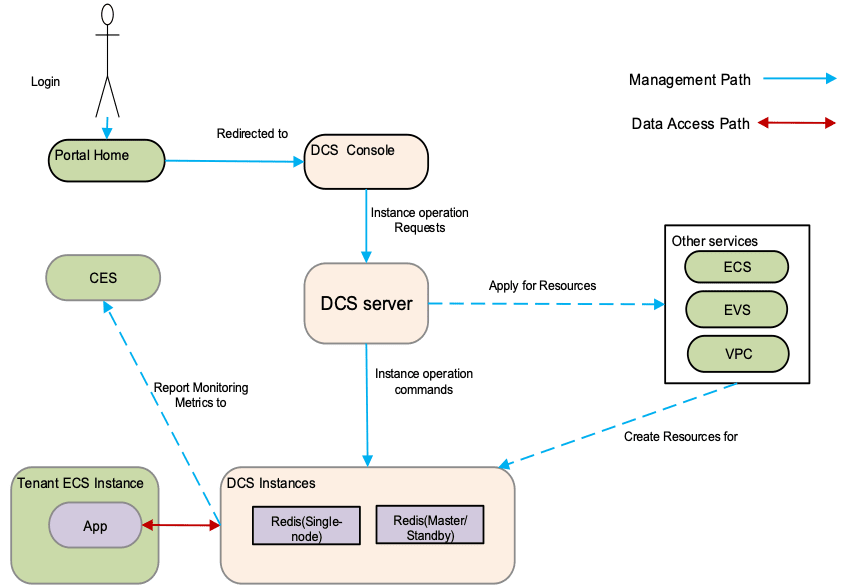

Distributed Cache Service (DCS) est un service de stockage key-value fiable et évolutif entièrement hébergé sur la plate-forme Cloud Computing. Avec la technologie distribuée, DCS prend en charge les caches à grande échelle et l’accès hautement simultané.

DCS est construit sur Redis, qui est open source ainsi que la norme de facto pour les caches Web. DCS prend en charge une série de structures de données, telles que chaîne, liste, ensemble et ensemble ordonné. DCS offre une disponibilité, une stabilité et une facilité d’utilisation standard.

Des services complets de calcul, de stockage et de maintenance (voir 9.3 Dépendance au service) doivent être lancés avant de déployer le DCS.

Caractéristiques

Caractéristiques du DCS :

- Partage multi-tenant

En tant que service cloud natif, DMS est directement disponible pour une utilisation sans déployer de matériel ou de logiciel.

- Une large gamme de variantes d’instance de cache

DMS fournit une console Web pour les tenants, leur permettant de gérerLes variantes d’instance de cache vont de 2 Go à 64 Go, augmentant la flexibilité du service DCS.

- Modes d’instances de cache multiples

Fournissez un mode nœud unique et maître / veille, et l’utilisateur peut choisir de manière flexible différents modes en fonction des besoins de l’entreprise.

- Persistance des données

La persistance des données (à l’aide du disque local de la VM d’instance) est fournie pour les instances de cache s’exécutant en mode maître-veille. Cela garantit à la fois la fiabilité des données et les performances d’écriture / lecture des données.La persistance des données (à l’aide du disque local de la VM d’instance) est fournie pour les instances de cache s’exécutant en mode maître-veille. Cela garantit à la fois la fiabilité des données et les performances d’écriture / lecture des données.

- Gestion du cycle de vie des instances

Grâce à la console DCS, les utilisateurs peuvent démarrer, redémarrer, supprimer, modifier et arrêter les instances de cache, ainsi que changer les mots de passe des instances de cache.

- Extension de capacité en ligne

Grâce à la console DCS, les utilisateurs peuvent augmenter en ligne la capacité des instances de cache spécifiées et garantir au maximum la perte minimale de données.

- Facilité de maintenance

Un système complet de surveillance et d’alarme est disponible pour collecter diverses mesures de surveillance. Les mesures de surveillance du service DCS incluent les clés, le nombre de connexions client et le nombre de commandes traitées. Les mesures de surveillance du système incluent la mémoire, le processeur et l’utilisation du réseau.

- Intégration avec CES

Cloud Eye (CES) surveille les métriques de service DCS. Si les mesures de surveillance ne sont pas dans la plage acceptable, des alarmes et / ou des événements seront générés.

Bénéfices

Facile à utiliser

Une fois acheté par les utilisateurs, le DCS peut être utilisé comme un service standard.

Sécurité

Avec le système de gestion des identités et des accès (IAM) intégré, le DMS fournit un mécanisme d’authentification d’identité. Ce mécanisme empêche les utilisateurs non autorisés d’accéder aux messages de la file d’attente, offrant une protection renforcée pour les messages.

Grande capacité

Une seule instance de cache peut supporter jusqu’à 64 Go de mémoire.

Fiabilité

La persistance des données et la redondance maître-veille garantissent la fiabilité des données.

Compatibilité avec Redis

DCS prend en charge toutes les commandes d’accès aux données fournies par Redis. Par conséquent, les utilisateurs n’ont pas à se soucier de l’accès aux données après la migration de leurs applications vers le cloud.

DCS est un service entièrement géré, et les commandes de gestion ne peuvent être exécutées qu’à partir du chemin de gestion.

Facilité d’entretien

Les mesures de surveillance des services de l’ECL sont affichées sous forme graphique. Les utilisateurs peuvent se concentrer sur le développement.

Cas d’usage

- Mise en cache des pages Web

- Mise en cache de l’état

- Stockage des données

- Traitement des événements

Spécifications

- Variantes des instances de cache à nœud unique

Pour chaque instance de cache mono-noeud, la mémoire disponible est légèrement inférieure à la mémoire totale car une certaine quantité de mémoire est réservée aux frais généraux du système.

Variantes des instances de cache à nœud unique

| Nom d’instance |

Mémoire totale (Go) |

Mémoire disponible (Go) | Nombre maximal de connexions autorisées | Maximum Intranet Bandwidth (Mbit/s) |

| cache.m1.medium | 2 | 1.5 | 10000 | 128 |

| cache.m1.large | 4 | 3.2 | 10000 | 192 |

| cache.m1.xlarge | 8 | 6.8 | 10000 | 192 |

| cache.m2.small | 16 | 13.6 | 10000 | 256 |

| cache.m2.medium | 32 | 27.2 | 10000 | 256 |

| cache.m2.large | 64 | 58.2 | 12000 | 384 |

- Variantes des instances de cache sur les nœuds Master/Standby

Pour les instances de cache sur les nœuds master/standby, une grande quantité de mémoire est réservée à la persistance des données. Par conséquent, même si une instance de cache sur les noeuds master/standby a la même mémoire totale qu’une instance de cache mono-noeud, la mémoire disponible n’est que la moitié de la mémoire disponible de l’instance de cache mono-noeud.

Variantes des instances de cache tournant sur les nœuds master/standby

| Nom d’instance |

Mémoire totale (Go) |

Mémoire disponible (Go) | Nombre maximal de connexions autorisées | Maximum Intranet Bandwidth (Mbit/s) |

| cache.m1.medium | 2 | 1.5 | 10000 | 128 |

| cache.m1.large | 4 | 3.2 | 10000 | 192 |

| cache.m1.xlarge | 8 | 6.4 | 10000 | 192 |

| cache.m2.small | 16 | 12.8 | 10000 | 256 |

| cache.m2.medium | 32 | 25.6 | 10000 | 256 |

| cache.m2.large | 64 | 51.2 | 12000 | 384 |

- Composants et Version

Spécification de la version de Redis

| Composants | Version |

| Redis | 3.0.7 |

- Quota

Quota par tenant

| Item | Plage de valeurs par défaut | Valeur recommandée |

| Nombre d’instances | 1 à 10 | 5 |

| Mémoire | 1 à 800 Go | 400 Go |

Note

- Le quota de mémoire d’un tenant se réfère à la quantité accumulée de mémoire de toutes les instances de cache créées par le locataire, y compris le nœud unique, maître et standby.

- L’instance master/standby consommera deux fois plus de quota mémoire d’instances de cache mono-noeud de même niveau.