Cloud Public Openstack – Flexible Engine

Elastic Load Balance

Description

Le répartiteur de charge à l’usage permet de distribuer le trafic réseau entre des serveurs virtuels regroupés en pool.

Votre Load Balancer peut répartir des charges visibles d’internet ou des environnements entièrement interne à vos VPC.

Ce service est un outil indispensable pour mettre en place des architectures en haute disponibilité. Il est par exemple possible d’utiliser simplement un répartiteur de charge pour faire fonctionner des serveurs en mode multi-maitre, chacun contribuant à traiter une partie du trafic.

La mise en place du load-balancer s’effectue en quelques étapes très simples via la console ou via API. Il peut répartir n’importe quel type de connexion TCP ainsi que des sessions http et HTTPS.

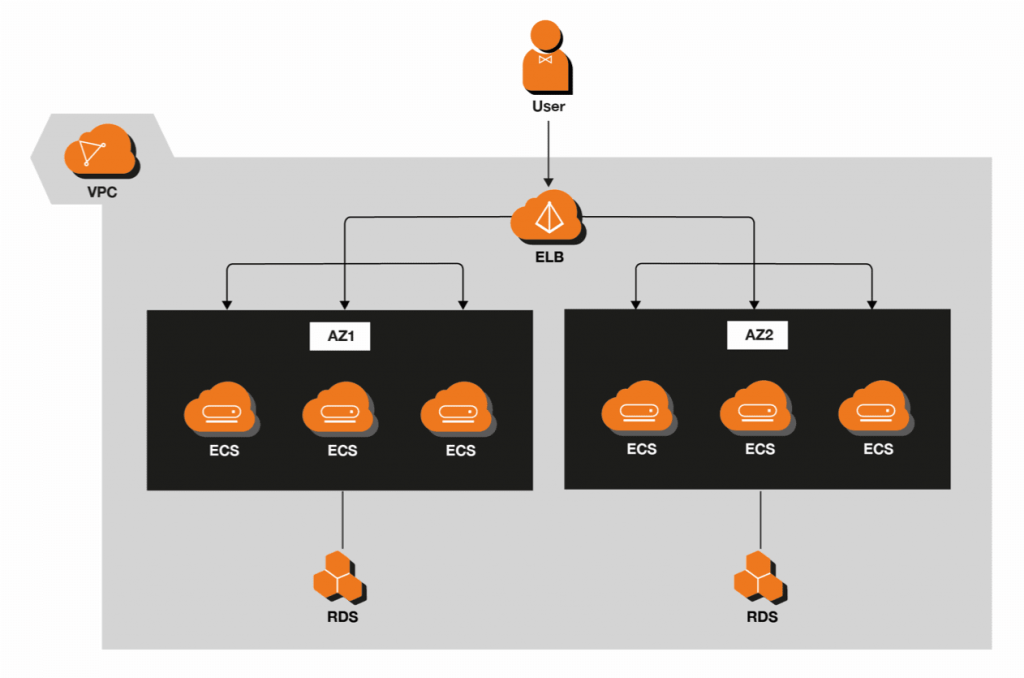

Ce service est particulièrement adapté à la mise en place d’architecture multi site puis qu’il permet de distribuer le trafic entre plusieurs zones de disponibilité (par exemple entre les deux serveurs basés en France).

Scénario d’application : reprise d’activité

ELB distribue du trafic entrant à travers les AZ, permettant ainsi une reprise d’activité après sinistre en temps réel. Les entreprises comme les banques peuvent utiliser ELB pour garantir une grande disponibilité de service.

Fonctionnalités

- Groupes d’AS avec des politiques paramétrables.

- La répartition de charge sur les flux HTTP / HTTPS / TCP à destination d’un pool de serveurs

- Supporte les terminaisons SSL

- La répartition de charge inter-AZ

- Autoscaling en fonction du trafic

- Capacité d’extension linéaire (élimination des SPOFs)

- Supporte le monitoring de métriques : trafic entrant et sortant, nouvelles requêtes, requêtes simultanées, paquets de données entrants et sortants, nombre de connexion, connexions inactives.

- Configuration de Health Check sur les instances

Répartiteur de charge pour un réseau privé

Le répartiteur de charge de réseau privé n’a que des adresses IP privées, peuvent seulement diriger les requêtes de clients avec un accès au VPS pour le répartiteur de charge.

Si votre application présente plusieurs niveaux, par exemple des serveurs Web qui doivent être connectés à Internet et des serveurs de base de données qui sont seulement connectés aux serveurs Web, vous pouvez concevoir une architecture qui utilise des répartiteurs de charge internes et Web.

Créer un répartiteur de charge de réseau public et enregistrer les serveurs Web avec lui. Créer un répartiteur de charge de réseau privé et enregistrer les serveurs de base de données avec lui. Les serveurs Web reçoivent des requêtes du répartiteur de charge de réseau public et envoie des requêtes pour les serveurs de base de données vers le répartiteur de charge de réseau public. Les serveurs de base de données reçoivent des requêtes du répartiteur de charge de réseau public.

Le répartiteur de charge de réseau privé envoie des requêtes à différentes zones disponibles.

Bénéfices

Cross-Datacenter

La possibilité d’établir un Load Balancer entre deux DataCenters d’une même zone de disponibilité vous permet de mettre en place facilement des stratégies de haute disponibilité.

Performant

Un Load Balancer permet jusqu’à 100 000 connexions concurrents, et jusqu’à 5 auditeurs. Un auditeur peut lui gérer jusqu’à 100 serveurs virtuels en back end.

Economique

Le prix du service est décompté à l’usage.